L’analisi dei rischi rappresenta il fondamento per la gestione efficace della sicurezza delle informazioni e del rischio cyber all’interno di un’organizzazione.

Secondo tutte le best practice e i framework di sicurezza, infatti, è solo attraverso un’attenta valutazione dei potenziali rischi che un’organizzazione può implementare misure di sicurezza adeguate e efficaci per proteggere i propri asset.

Anche le normative europee più recenti, come GDPR, DORA e NIS2, sottolineano l’importanza dell’analisi dei rischi come punto di partenza per la gestione della sicurezza.

Tuttavia, persino nelle realtà che adottano processi formali di risk assessment, è frequente osservare un divario critico. Ecco come superare questa criticità e in cosa consiste l’approccio Fair.

Indice degli argomenti

L’analisi dei rischi

Molte analisi si riducono a esercizi documentali, focalizzati sul soddisfacimento dei requisiti normativi anziché sull’allineamento agli obiettivi di business.

Questo approccio “a scatola chiusa” genera cataloghi di rischi generici, privi di contestualizzazione operativa, che difficilmente informano le decisioni strategiche o guidano l’allocazione delle risorse.

Il risultato sono misure di sicurezza disgiunte dalle reali priorità aziendali, investimenti inefficaci e una percezione distorta del rischio che mina la capacità di anticipare minacce concrete.

Per superare questa criticità, è essenziale che le organizzazioni adottino un approccio più rigoroso e strategico all’analisi dei rischi, perfettamente allineato con gli obiettivi di business dell’organizzazione, in modo da poter identificare, prioritizzare e gestire efficacemente i rischi, al fine di supportare le decisioni strategiche e tattiche con dati e informazioni attendibili.

Approccio qualitativo e quantitativo

Nell’ambito dell’analisi dei rischi, esistono due approcci principali: quello qualitativo e quantitativo.

Entrambi gli approcci richiedono tipicamente di valutare due elementi tipici che concorrono al calcolo del rischio:

- probabilità o verosimiglianza, che risponde alla domanda: “Qual è la frequenza dell’accadimento?”;

- impatto o conseguenza, che risponde alla domanda: “Qual è la ricaduta dell’evento?”.

Approccio qualitativo: vantaggi e limiti

Ampiamente diffuso per la sua immediatezza operativa, l’approccio qualitativo classifica i rischi attraverso scale ordinali come “alto”, “medio” o “basso”, spesso associate a codici cromatici (per esempio, rosso, giallo, verde) e a matrici di tipo “risk heat map”.

Questo approccio è semplice da implementare e richiede meno dati e risorse rispetto all’approccio quantitativo, ma presenta alcuni limiti significativi.

In primo luogo, i criteri utilizzati per definire queste categorie sono spesso soggettivi e possono variare notevolmente da persona a persona. Inoltre risulta difficile interpretare e comunicare i risultati in modo chiaro e univoco.

Cosa significa esattamente “alto” o “basso” in termini di rischio? Come si possono confrontare e priorizzare i rischi in base a categorie così generiche? Senza una quantificazione le valutazioni restano astratte, ostacolando il dialogo con i decisori aziendali e rendendo opache le analisi costi-benefici.

Questa ambiguità genera decisioni poco mirate: investimenti in contromisure spesso non correlati alle priorità business, o viceversa, tolleranza di rischi critici per mancanza di cognizione del loro impatto economico, alimentando divergenze tra reparti IT e direzione.

L’approccio quantitativo

Al contrario, sostituisce le etichette vaghe con valori numerici: probabilità espresse in percentuali, impatti monetari stimati, tempi di recupero calcolati in giorni.

Questo consente di tradurre i rischi in termini comprensibili al business, come perdite finanziarie attese (ALE – Annual Loss Expectancy) o ritorni sugli investimenti in sicurezza (ROSI – Return on Security Investment) e di eseguire analisi costi-benefici precise.

Se una minaccia ha un costo atteso annuo di 1,5 milioni di euro, è possibile valutare se investire 800 mila euro in una misura di difesa che riduca tale rischio al 50% è economicamente sensato.

Tuttavia, la sua adozione è ancora marginale, non per mancanza di vantaggi, ma per una carenza culturale e infrastrutturale.

Molte organizzazioni non hanno infatti a disposizione dati storici sufficienti sulla frequenza degli incidenti di sicurezza, sui costi diretti e indiretti associati alla loro gestione o sull’effettivo impatto sulle proprie attività e percepiscono il modello quantitativo come complesso o dispendioso.

Il risultato è paradossale: pur riconoscendo la superiorità analitica dei numeri, si continua a preferire il “linguaggio dei colori”, perpetuando una gestione del rischio basata spesso su sensazioni anziché evidenze.

La metodologia FAIR emerge come ponte tra questi mondi, dimostrando che la quantificazione è possibile anche in assenza di dati perfetti, grazie a tecniche di stima calibrate e all’integrazione di fonti eterogenee.

I dati necessari per l’analisi dei rischi

Uno dei principali ostacoli all’adozione di un approccio quantitativo nella gestione dei rischi è la percezione che manchino i dati necessari per effettuare stime precise.

Spesso si è erroneamente convinti di non avere informazioni sufficienti per effettuare stime affidabili, quando in realtà il problema risiede nella difficoltà di individuare e utilizzare le fonti di dati già disponibili.

La sfida consiste nel riconoscere e sfruttare queste fonti di dati, anche se non sono immediatamente evidenti o se richiedono un po’ di lavoro per essere organizzate e analizzate.

Per esempio, in mancanza di dati sugli incidenti passati possono essere utilizzati dati esterni, come le statistiche pubblicate da enti governativi, i report di società di sicurezza specializzate, i dati delle assicurazioni cyber risk o persino provenienti da forum e dalle community online dedicate alla cyber security, consentendo di stimare probabilità di eventi anche per organizzazioni che non hanno esperienza diretta.

Le informazioni richieste potrebbero inoltre derivare da fonti interne che non si considerano immediatamente pertinenti alla sicurezza delle informazioni o al rischio cyber.

Per esempio, i dati operativi, i rapporti di audit interni ed esterni e persino i feedback dei clienti possono rivelare indicatori preziosi per valutare i rischi.

Siamo infine spesso portati a credere che sia necessario raccogliere quantità enormi di dati per ottenere risultati affidabili.

Tuttavia, un numero minore di dati ben scelti e pertinenti può essere sufficiente per effettuare analisi significative. La chiave sta nel riconoscere che non è necessario avere dati perfetti per iniziare.

La metodologia Fair, infatti, incoraggia l’uso di ipotesi calibrate e di dati “approssimativi ma direzionati”, integrando informazioni parziali in modelli che riducono l’incertezza, con una serie di tecniche quali la partenza dall’assurdo, la decomposizione del problema, il test sulla confidenza della stima, la messa in discussione delle assunzioni.

Trasformare le incertezze in distribuzioni statistiche utili

Infine, la metodologia Fair suggerisce l’utilizzo del metodo Monte Carlo che consente di lavorare con intervalli di probabilità anziché numeri precisi, trasformando incertezze in distribuzioni statistiche utili.

I dati sono quindi normalmente più accessibili di quanto si creda e la quantificazione non richiede una precisione assoluta, bensì un approccio strutturato per integrare le informazioni disponibili.

La metodologia Fair

La metodologia Fair (Factor analysis of information risk) è un approccio quantitativo per l’analisi dei rischi di sicurezza delle informazioni.

Sviluppato originariamente da Jack Jones e promossa dal ”Fair Institute”, questo approccio si basa sull’idea che i rischi di sicurezza possano essere analizzati e valutati utilizzando un approccio sistematico e quantitativo.

Open Fair è la versione standardizzata e formalmente riconosciuta di Fair, sviluppata e mantenuta dall’organizzazione internazionale The Open Group.

Open Fair rappresenta un modello di rischio scalabile a livello aziendale, con una tassonomia e ontologia standard per il rischio informativo e operativo, criteri di raccolta dati, scale di misura e costrutti modellistici per analizzare scenari complessi.

È stato sottoposto a un processo rigoroso di revisione e sviluppo tramite consenso aperto, diventando uno standard internazionale per la gestione del rischio informativo. Open Fair vanta il supporto da parte di pubblicazioni ufficiali, corsi di formazione accreditati e certificazioni per professionisti.

Far si concentra sull’analisi dei due elementi fondamentali che caratterizzano ogni rischio: la probabilità che un evento si verifichi e l’impatto che tale evento potrebbe avere sull’organizzazione.

L’approccio Fair consente di quantificare i rischi in termini di perdita finanziaria, danneggiamento della reputazione o altro tipo di impatto sul business, facilitando così la prioritarizzazione degli interventi e l’allocazione ottimale delle risorse.

Inoltre, la metodologia sottolinea che il rischio è un evento incerto e che non bisogna concentrarsi su ciò che è possibile, ma su quanto un determinato evento sia probabile. L’approccio probabilistico si applica a ogni fattore preso in esame.

Il rischio nell’approccio Fair

In Fair, il rischio è definito come “la probabile frequenza e la probabile entità di una perdita futura”.

Il metodo scompone ulteriormente il rischio suddividendo i diversi fattori che compongono la probabile frequenza e la probabile perdita che possono essere misurati in un numero quantificabile.

I vantaggi

Uno dei punti di forza della metodologia Fair è la sua flessibilità. Essa si può applicare a diversi livelli dell’organizzazione, dai singoli asset informativi fino all’intero portafoglio di rischi, e si adatta a vari contesti operativi.

Fair incoraggia infine l’utilizzo di stime calibrate basate sul giudizio esperto e su dati storici disponibili, riducendo la dipendenza da informazioni precise e dettagliate.

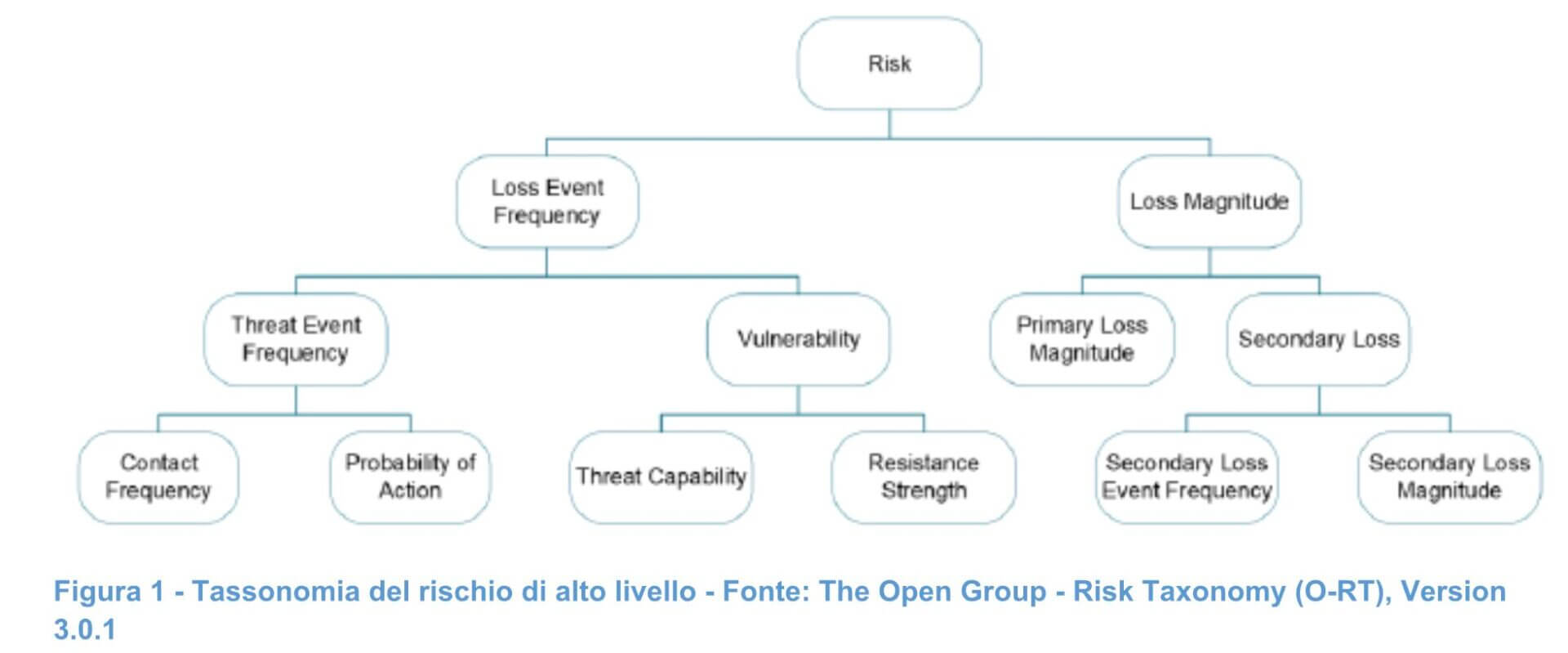

Tassonomia dei rischi

La tassonomia dei rischi è un elemento fondamentale della metodologia Fair. Si tratta di una struttura gerarchica che consente di classificare ed organizzare i diversi fattori che determinano i rischi che possono impattare sulla sicurezza delle informazioni.

Come si può vedere dall’albero, la tassonomia è composta da diversi livelli:

- i livelli più alti dell’albero rappresentano i fattori più generali:

- quelli più bassi rappresentano i fattori più specifici.

Un aspetto importante della tassonomia dei rischi è che consente di valutare i fattori di rischio in modo top-down. Ciò significa che se si hanno informazioni disponibili sui livelli più alti dell’albero è possibile valutarli direttamente senza dover scendere ai livelli inferiori.

Per esempio, se si conosce la probabilità di una violazione dei dati, non è necessario valutare separatamente i fattori di rischio che contribuiscono a questa probabilità.

Se tuttavia le informazioni sui livelli più alti dell’albero non sono disponibili, è possibile scendere ai livelli inferiori e dividere la stima dei fattori di rischio in modo più dettagliato.

Un esempio

Se non si conosce la probabilità di una violazione dei dati, ma si conoscono i fattori di rischio che contribuiscono a questa probabilità, come la frequenza degli accessi non autorizzati o la presenza di vulnerabilità nel sistema, è possibile valutare questi fattori di rischio separatamente e poi combinarli per ottenere una stima della probabilità di violazione dei dati.

Se non abbiamo dati sufficienti a stimare direttamente la Loss Eevent frequency (Lef), scendiamo di un livello, stimando quindi:

- Threat event frequency (Tef): quantità di tentativi di attacco all’anno (esempio: “attaccanti tentano 20 volte all’anno”).

- Vulnerability (V): probabilità che un tentativo riesca (esempio: “Il 10% dei tentativi supera la difesa”).

Si ottiene, quindi:

LEF = TEF × V → Se TEF è 20 e V è 10%, LEF = 2 eventi all’anno.

Questo approccio consente di adattare la valutazione dei rischi alle esigenze specifiche dell’organizzazione e ai dati disponibili.

Inoltre, la tassonomia dei rischi fornisce una struttura logica e coerente per l’analisi dei rischi, che aiuta a garantire che tutti i fattori di rischio rilevanti siano presi in considerazione.

Come stimare i valori: metodi e applicazioni pratiche

La stima del rischio si basa sulla definizione di rischio specifici, scomposte in sotto-scenari che considerano asset (esempio, informazioni dei clienti), agente di minaccia (esempio, Cybercrime), tipo di minaccia (esempio, intento malevolo), tipo di effetto (esempio, riservatezza).

Le stime presentano un valore minimo e massimo che ne specificano l’intervallo.

Una stima è accurata quando il risultato misurato in futuro si trova all’interno di tale intervallo. Poiché il futuro è incerto e i modelli di stima sono rappresentazioni imperfette di un mondo imperfetto, le stime saranno in parte imprecise. Le stime hanno una probabilità di essere accurate.

Questa probabilità può essere aumentata a spese della precisione della stima. In altre parole, l’aumento dell’intervallo di una stima aumenta la probabilità che sia accurata, ma va a scapito di una minore precisione della stima stessa. A un certo punto, anche se accurata, una stima imprecisa non è più utile.

Il compromesso pratico proposto da Fair è che le stime dovrebbero essere accurate nel 90% dei casi. Questa probabilità di accuratezza rappresenta un

compromesso tra la probabilità che la stima sia accurata e il miglioramento della precisione.

Equilibrio tra accuratezza e precisione

Per raggiungere questo equilibrio tra accuratezza e precisione, chi svolge l’analisi deve avere la certezza che il risultato futuro osservato non sarà inferiore al minimo della stima più di una volta su 20, ovvero nel 5% dei casi.

Allo stesso modo, l’analista deve avere la certezza che il risultato futuro materializzato e osservato non sarà superiore al valore massimo della stima più di una volta su venti, ovvero nel 5% dei casi.

Quindi, per ciascun parametro, viene definito un valore minimo, un valore più probabile e un valore massimo, riflettendo così l’incertezza intrinseca nelle valutazioni. Questo approccio a intervalli consente di catturare la variabilità e di evitare stime puntuali troppo rigide o fuorvianti.

Le stime basate su intervalli, a differenza di quelle basate su valori puntuali, che possono essere facilmente sommati, sottratti o moltiplicati, sono difficili da elaborare e combinare per ottenere per esempio un rischio totale per più scenari. A tale scopo dovranno essere utilizzati metodi di simulazione statistica.

Il metodo Monte Carlo

Uno dei metodi statistici più utilizzati per elaborare stime basate su intervalli è il metodo Monte Carlo.

Questa tecnica si basa su simulazioni ripetute migliaia di volte, al fine di generare una distribuzione probabilistica degli esiti possibili combinando i valori stimati degli input.

Possono essere quindi generati migliaia di valori che rispettano i vincoli previsti (minimo, massimo, probabilità e distribuzione). I valori generati rappresentano valori di input che vengono utilizzati per creare, attraverso operazioni aritmetiche, un valore di output per un certo scenario.

I valori di output avranno le stesse caratteristiche di probabilità e incertezza degli input e potranno essere utilizzati per ulteriori simulazioni. Questo permette di ottenere una rappresentazione più realistica e completa del rischio, evidenziando non solo il valore medio atteso, ma anche gli scenari peggiori e migliori, e supportando decisioni basate su percentili e curve di perdita cumulativa (Loss Exceedance Curve).

Esempio di attacco ransomware

Supponiamo di valutare il rischio di un attacco ransomware su un sistema aziendale. Si stima che la frequenza annua di perdite dovute all’attacco possa variare da 0,1 a 0,5 volte (minimo-massimo), con un valore più probabile di 0,2.

La perdita per evento potrebbe essere stimata tra 50.000 e 1.000.000 euro, con un valore più probabile di 150.000 euro.

Applicando la simulazione Monte Carlo, si ottiene una distribuzione delle perdite annuali che permette di identificare, per esempio, che nel 90% dei casi la perdita non supererà un certo valore, mentre nel 10% potrebbe essere molto più elevata, fornendo così una base solida per la pianificazione delle contromisure e la definizione del budget di sicurezza.

Valutazione del rischio per un determinato asset

Vediamo ora un esempio completo di valutazione del rischio per un asset specifico:

- identificazione dell’asset: selezioniamo un asset critico, come per esempio un database che contiene informazioni sui clienti;

- agenti di minaccia e minacce: identifichiamo gli agenti di minaccia potenziali (per esempio cybercrime, dipendenti interni) e le specifiche minacce che potrebbero colpire l’asset (per esempio accesso non autorizzato, errore umano);

- effetti: consideriamo gli effetti della violazione in termini di riservatezza, integrità e disponibilità;

- stima della Loss event frequency: utilizziamo intervalli per stimare la Lef per ciascun tipo di minaccia (ad esempio tra 0,1 e 5 all’anno con 0,5 come valore più probabile e confidenza moderata per l’accesso non autorizzato). Se non abbiamo dati sufficienti scendiamo di un livello nella tassonomia;

- stima della Loss magnitude: utilizziamo intervalli per stimare la LM per ciascun tipo di minaccia (per esempio tra 5.000 e 100.000 euro con 15.000 euro come valore più probabile). Se non abbiamo dati sufficienti scendiamo di un livello nella tassonomia;

- applicazione del metodo Monte Carlo: aspplichiamo il metodo per generare casualmente valori all’interno degli intervalli definiti per LEF e LM ed eseguiamo simulazioni multiple per ottenere la distribuzione del rischio;

- analisi dei risultati: utilizziamo i risultati per valutare il rischio associato all’asset.

Prospettive future

La metodologia Fair può fornire una valutazione quantitativa del rischio basata su una tassonomia rigorosa e una scomposizione dettagliata dei fattori di rischio, permettendo di stimare con maggiore precisione la frequenza e l’impatto degli eventi avversi, anche in assenza di dati storici completi.

Questo approccio non solo facilita decisioni più informate e trasparenti, ma consente anche di prioritizzare gli investimenti in sicurezza e mitigazione in modo economicamente efficiente.

Fair Institute ed Open Group rendono disponibili risorse per approfondire il funzionamento della metodologia, corsi di formazione anche in preparazione alla certificazione dei professionisti, tool per eseguire l’analisi del rischio.