Cloudflare ha spiegato che il prolungato down del 18 novembre 2025 sarebbe da attribuire a un sistema di gestione dei bot modificato, in cui un file ha superato la dimensione massima.

Ma il problema non è la causa contingente del peggior disservizio dal 2019 che ha impedito di accedere a molti siti, fra cui spiccano ChatGPT, X e Spotify, bensì la fragilità delle infrastrutture critiche e l’eccessiva dipendenza da poche decine di operatori. Il down di uno, manda in tilt numerosi player.

“C’è qualcosa di ironico nell’evoluzione che ha avuto la rete”, commenta Alessandro Curioni, Fondatore di DI.GI Academy, specializzato in Information Security & Cybersecurity: “Nata per essere resiliente in quanto distribuita, oggi, che si parla solo di resilienza, mostra continuamente la sua fragilità in quanto concentrata”.

Secondo Pierluigi Paganini, “il blackout globale di Cloudflare ha mostrato quanto l’affidabilità dei servizi digitali dipenda da un numero ristretto di grandi provider“.

“Non si tratta solo di un altro contrattempo tecnico. È un esempio perfetto di quanto siamo dipendenti da pochi grandi fornitori di servizi e dei pericoli che questo comporta”, conferma Ramutė Varnelytė, Ceo di IPXO, la piattaforma di gestione delle risorse IP.

Ecco come mitigare i rischi, adottando soluzioni di cyber resilienza delle infrastrutture critiche.

Indice degli argomenti

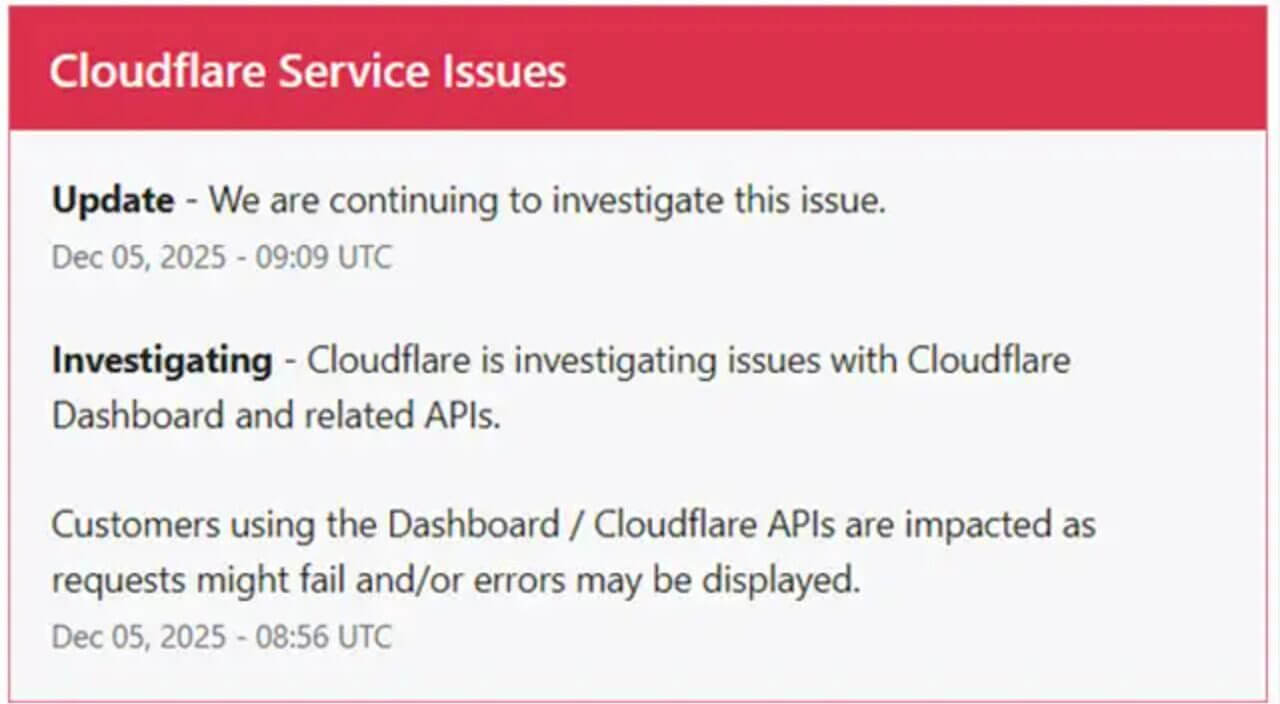

Nuovo outage il 5 dicembre 2025

Questa volta è durato solo mezz’ora, ma il nuovo down di Cloudflare ha prodotto disservizi su Dashboard, API e sul servizio serverless Cloudflare Workers, che migliaia di developer impiegano per l’automatizzazione di opzioni delle loro app.

“L’episodio di questa mattina è l’ennesimo promemoria di quanto sia fragile un’Internet che concentra funzioni critiche su pochi grandi fornitori di infrastruttura”, evidenzia Pierluigi Paganini, analista di cyber security e Ceo Cybhorus.

Down 5-12-2025: Il rischio sistemico

Il nuovo down ha colpito LinkedIn, Vimeo, Canva, Vinted e Perplexity, Zoom, fra gli altri.

“Quando un attore come Cloudflare ha un problema, seppur di breve durata, l’effetto non è più il down di un singolo sito, ma uno tsunami che oscura contemporaneamente media, e Commerce, servizi finanziari, SaaS aziendali e perfino gli strumenti pensati per monitorare i disservizi, come downdetector“, avverte Paganini.

I motivi dell’outage sarebbero gli stessi dell’ultima volta.

“Il punto non è solo la qualità tecnica del singolo provider, ma il rischio sistemico: CDN, DNS gestito, WAF e protezione DDoS sono diventati punti di concentrazione’ imprescindibili. Se uno di questi servizi è indisponibile, una porzione significativa della superficie pubblica del web diventa irraggiungibile. In termini di resilienza, è l’equivalente digitale di avere un’unica centrale elettrica per un intero Paese, un suo malfunzionamento ci porterebbe inevitabilmente al buio.

Dipendiamo in modo assoluto da un singolo attore? Troppo spesso la risposta è che la ridondanza è stata sacrificata sull’altare della semplicità e del costo“, conclude Paganini: “Dal punto di vista della ‘sicurezza nazionale digitale’, questi episodi mostrano anche come un singolo punto di failure possa avere effetti quasi equivalenti a un attacco coordinato su larga scala. Non serve compromettere migliaia di siti, basta colpire uno dei grandi hub. Ridisegnare architetture con provider alternativi pronti ad intervenire in caso di malfunzionamenti del fornitore principale, maggiore autonomia locale e test periodici di continuità operativa non sono un lusso, ma una misura di igiene minima indispensabile a garantire continuità e resilienza. Diversificare le dipendenze infrastrutturali è oggi una scelta di sicurezza, non solo di performance”.

Cloudflare in down: il problema è la resilienza delle infrastrutture critiche

Il disservizio di Cloudfare si ripercuote su gran parte della Rete, perché l’azienda offre i servizi (DNS, CDN, Reverse Proxy, Firewall, protezione DDoS) a un quinto dei siti web nel mondo.

In questo caso, non c’è stato un cyber attacco, ma è bastato un errore (autorizzazione modificata di uno dei sistemi di database che ha raddoppiato le dimensioni di un file, in uso da parte del sistema di gestione dei bot – contenente la lista dei bot da bloccare -, distribuito a tutti i nodi della rete di Cloudflare) per provocare il down.

Il vero problema, però, non è tanto il software che incanala il traffico che non è in grado di effettuare la gestione di file con dimensione oltre un certo limite, ma la fragilità delle infrastrutture critiche e le soluzioni possibili, a partire dalla cyber resilienza, da adottare per mitigare questi rischi.

“Tutto il sistema ha maturato una dipendenza completa da poche decine di operatori. Le infrastrutture critiche non fanno eccezione”, spiega Alessandro Curioni: “Iniziate a immaginare un ‘balletto del ritorno’ di quelli che abbiamo già visto nell’ambito delle tecnologie digitali. Se poi non è possibile uscire dal cloud allora si tratta di immaginare un piano B analogico magari con tanto di carta e penna”.

Ma ovviamente questo è un paradosso. E serve più cyber resilienza.

“Sia questo incidente che la recente interruzione di AWS verificatasi alla fine di ottobre dovrebbero servire da ulteriore monito. Cloudflare attualmente contribuisce a gestire e proteggere il traffico di circa il 20% del web. Naturalmente, gli effetti dell’interruzione si sono fatti sentire in tutto il mondo. Anche se è stato divertente scherzare sul fatto che, almeno per un giorno, potevamo essere sicuri che ChatGPT non avesse scritto nessuno dei contenuti che stiamo leggendo, il messaggio chiave che dovremmo trarre da questo incidente è l’importanza di un’infrastruttura resiliente e la necessità di un piano attuabile“, aggiunge Ramutė Varnelytė.

Ecco le soluzioni da adottare per mitigare i rischi

Poiché non è possibile fare a meno del cloud computing e al momento è altissima la dipendenza da pochi provider, le soluzioni da adottare per mitigare i rischi riguardano la cyber resilienza e una maggiore sovranità digitale, soprattutto in Europa. Nel frattempo, bisogna assicurare la business continuity.

Infatti, “per ridurre l’impatto di futuri guasti serve una strategia tecnica più matura“, spiega Pierluigi Paganini, “le aziende possono adottare approcci multi-cloud e multi-CDN con failover DNS automatici, distribuire carichi e dati su aree geografiche e data center diversi, e mantenere repliche eterogenee per garantire continuità”.

In definitiva, “è fondamentale disporre di piani di disaster recovery efficaci e testati periodicamente. Monitoraggi continui, esercitazioni periodiche di failover e accordi con SLA chiari (Service Level Agreement, che fissano gli obiettivi contrattuali verso clienti e fornitori, ndr) accelerano la gestione delle crisi. Infine buona pratica decentralizzare funzioni critiche come autenticazione, DNS, API e logging riducendo i punti di vulnerabilità e aumentando la resilienza complessiva”.