Gli agenti basati su Large Language Model (LLM) stanno rapidamente passando da prototipi di ricerca a sistemi implementati, sollevando nuove e urgenti sfide in termini di sicurezza.

A differenza dei chatbot statici, gli agenti LLM interagiscono con strumenti esterni, dati e servizi, creando nuovi threat model che possono causare a danni concreti già nelle fasi iniziali di sviluppo.

Ecco le minacce agli agenti LLM, secondo la tassonomia delle migliori pratiche di sicurezza che copre l’intero ciclo di sviluppo e valuta l’adozione di tali raccomandazioni nella pratica.

L’analisi si basa su un corpus di letteratura accademica, letteratura grigia e casi reali, fornendo un quadro generale per sviluppare strategie di mitigazione del rischio e promuovendo la standardizzazione, evidenziando le lacune delle pratiche correnti e gettando le basi per future ricerche su agenti LLM sicuri.

Indice degli argomenti

Un framework unificato per la progettazione, lo sviluppo e l’impiego sicuro degli agenti LLM

Nonostante la crescente preoccupazione da parte dei ricercatori del mondo accademico, industriale e governativo, le pratiche standard per la messa in sicurezza degli LLM rimangono frammentate.

Gran parte dei progressi, sia nella ricerca che nell’implementazione, proviene dall’industria, ma questi contributi sono spesso legati a ecosistemi proprietari o a incentivi commerciali, il che ne limita la generalizzabilità e l’obiettività.

Per colmare questa lacuna, sistematizziamo le conoscenze provenienti dall’accademia, dall’industria e dai deployment reali, fornendo un framework unificato per la progettazione, lo sviluppo e l’impiego sicuro degli agenti LLM.

Le 4 proprietà degli agenti LLM

Seguendo la definizione di Chan [1], caratterizziamo l’agency nei sistemi algoritmici attraverso quattro proprietà chiave:

- il raggiungimento di obiettivi non completamente specificati;

- l’azione diretta nel mondo senza mediazione umana;

- l’esibizione di un comportamento orientato agli obiettivi;

- e la capacità di pianificare a lungo termine.

Questa caratterizzazione evidenzia le capacità che sollevano nuove preoccupazioni in termini di sicurezza.

Architettura di riferimento

In pratica, il motore centrale di ragionamento e pianificazione di un LLM esercita l’agency attraverso lo scaffolding software che lo connette a strumenti esterni. Questi strumenti gli permettono di percepire l’ambiente, di eseguire azioni e di delegare compiti a sistemi specializzati o ad altri agenti.

Tecniche come il reinforcement learning su task multi-step a lungo orizzonte rafforzano le capacità di un agente.

Confronto con lavori correlati

Una meta-analisi delle survey accademiche sulla sicurezza degli agenti LLM ha rivelato che meno di un terzo dei paper analizzati ha dettagliato una metodologia di revisione della letteratura ripetibile.

Solo tre paper hanno preso in considerazione esplicitamente la letteratura grigia e solo cinque hanno analizzato casi reali di agenti LLM.

In sintesi, nessuna delle fonti della letteratura revisionata era sufficiente a coprire sia il panorama delle minacce che quello della sicurezza secondo le tassonomie sviluppate.

Il lavoro di Huang su Maestro [2] ha descritto attacchi in diciannove delle venticinque classi di attacchi identificate, ma nessuna altra fonte ne ha coperte più della metà.

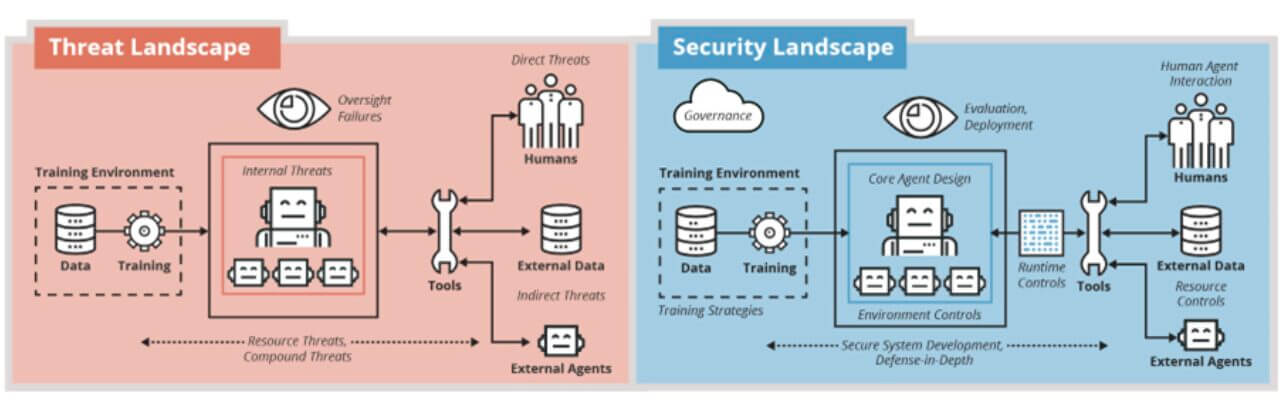

Le 7 superfici di minacce: la tassonomia

L’analisi delle fonti ha identificato 7 principali superfici di minaccia per gli agenti LLM: minacce dirette, minacce indirette, minacce interne, minacce alle risorse, fallimenti di supervisione, minacce composte e framework di threat modeling:

- minacce dirette;

- minacce indirette;

- interne;

- minacce alle risorse;

- fallimenti di oversight;

- minacce composte;

- framework.

Minacce dirette

Le minacce dirette si verificano a livello applicativo, dove l’utente interagisce con un agente. Gli input degli utenti al sistema possono causare vulnerabilità da direct prompt injection, uso non consentito o attacchi multimodali diretti.

Minacce indirette

I componenti connessi a un motore LLM centrale introducono ulteriori rischi. Il contenuto inserito automaticamente nei prompt come contesto è vulnerabile all’indirect prompt injection. Sono stati notati frequentemente tre componenti come suscettibili di attacco: gli strumenti, la base di conoscenza e gli agenti interni.

Tra le minacce specifiche, si annoverano il memory poisoning, il design insicuro dei plugin e gli exploit dei protocolli di comunicazione.

La minaccia interna

Il motore LLM che alimenta la percezione, il processo decisionale e le azioni di un agente può introdurre minacce interne.

Queste vulnerabilità possono manifestarsi durante lo sviluppo, ad esempio attraverso il data poisoning o il model backdoor, così come durante il deployment.

Le vulnerabilità del modello di base, come il misallineamento, le allucinazioni e l’inaccuratezza, rappresentano una minaccia costante.

Minacce alle risorse

Questi attacchi prendono di mira l’infrastruttura software e hardware sottostante che supporta l’agente.

Includono la compromissione di dispositivi fisici o componenti cyber, l’uso improprio delle risorse di elaborazione e gli attacchi alla catena di approvvigionamento delle dipendenze software integrate nell’agente.

Fallimenti di oversight

In alcuni sistemi agentici, gli utenti possono rivedere il ragionamento dell’agente e approvare le sue azioni.

Tuttavia, questo tipo di controllo può introdurre nuove vulnerabilità, favorendo l’over-trust attraverso spiegazioni non fedeli, sovraccaricando i revisori o facendo perdere di vista i problemi a causa di lacune di copertura o drift.

Minacce composte

La natura iterativa e interattiva degli agenti LLM crea nuove superfici di minaccia. I loop iterativi che gli agenti utilizzano per eseguire task multistep creano cascading failure dove il fallimento in uno step viene amplificato negli step successivi.

I sistemi che interagiscono con altri agenti autonomi sono suscettibili a dinamiche multi-agent avverse.

Framework

Alcuni paper fanno riferimento anche a modelli di minaccia già noti. In alcuni casi, sono stati citati invece di elencare minacce specifiche.

La letteratura sugli agenti LLM

Le minacce informatiche tradizionali sono motivo di crescente preoccupazione. I rischi tradizionali degli LLM riguardano principalmente le minacce specifiche del modello stesso e, a causa della loro limitata integrazione con i sistemi esterni, ricevono meno attenzione rispetto alle minacce informatiche tradizionali.

Tuttavia la letteratura sugli agenti LLM indica che le tradizionali minacce alla sicurezza informatica rappresentano una delle principali preoccupazioni per questi sistemi di IA.

Minacce informatiche ben note, come gli attacchi DoS, MITM e injection, sono state più volte oggetto di preoccupazione. Ciò fornisce prove a sostegno della tendenza in aumento di attingere ai principi di sicurezza del software esistenti per informare la sicurezza dei sistemi di IA.

Il mondo accademico, invece, pone l’accento sulle minacce interne, in particolare su quelle direttamente correlate al modello di base, come il disallineamento e l’allucinazione, ma anche sugli errori di ragionamento e di pianificazione, sugli attacchi backdoor e sulle minacce emergenti quali l’inganno e l’intrigo.

Al contrario, l’industria si concentra sulle minacce derivanti dall’integrazione dei sistemi, in particolare sulle minacce indirette, sui fallimenti IAM, sugli attacchi e sull’uso improprio degli strumenti, sull’iniezione indiretta di prompt e sulle minacce alla catena di approvvigionamento.

Queste diverse prospettive riflettono le differenze negli incentivi: i team accademici si concentrano su nuove e emergenti modalità di fallimento, mentre i team industriali danno priorità alle minacce operative nei sistemi implementati.

Queste due prospettive sono complementari e contribuiscono a delineare una tassonomia più completa delle minacce degli agenti, ma suggeriscono anche delle opportunità per la comunità accademica di impegnarsi maggiormente nelle questioni di livello sistemico.

Una convergenza verso framework e terminologia condivisi

Le tassonomie strutturate delle minacce aiutano i professionisti a confrontare i sistemi, stabilire le priorità delle misure di mitigazione e accumulare prove tra i vari studi, fornendo una struttura e una terminologia condivise.

Nella nostra revisione, i riferimenti alle tassonomie esistenti erano scarsi e frammentati tra i vari framework. La terminologia utilizzata per descrivere le minacce variava notevolmente e abbiamo riscontrato una lunga serie di termini che descrivevano minacce identiche o molto simili.

Una convergenza verso un insieme condiviso di framework e terminologia aiuterebbe a tradurre le conoscenze acquisite dalla ricerca alla pratica e dalla sicurezza informatica a quella dell’IA.

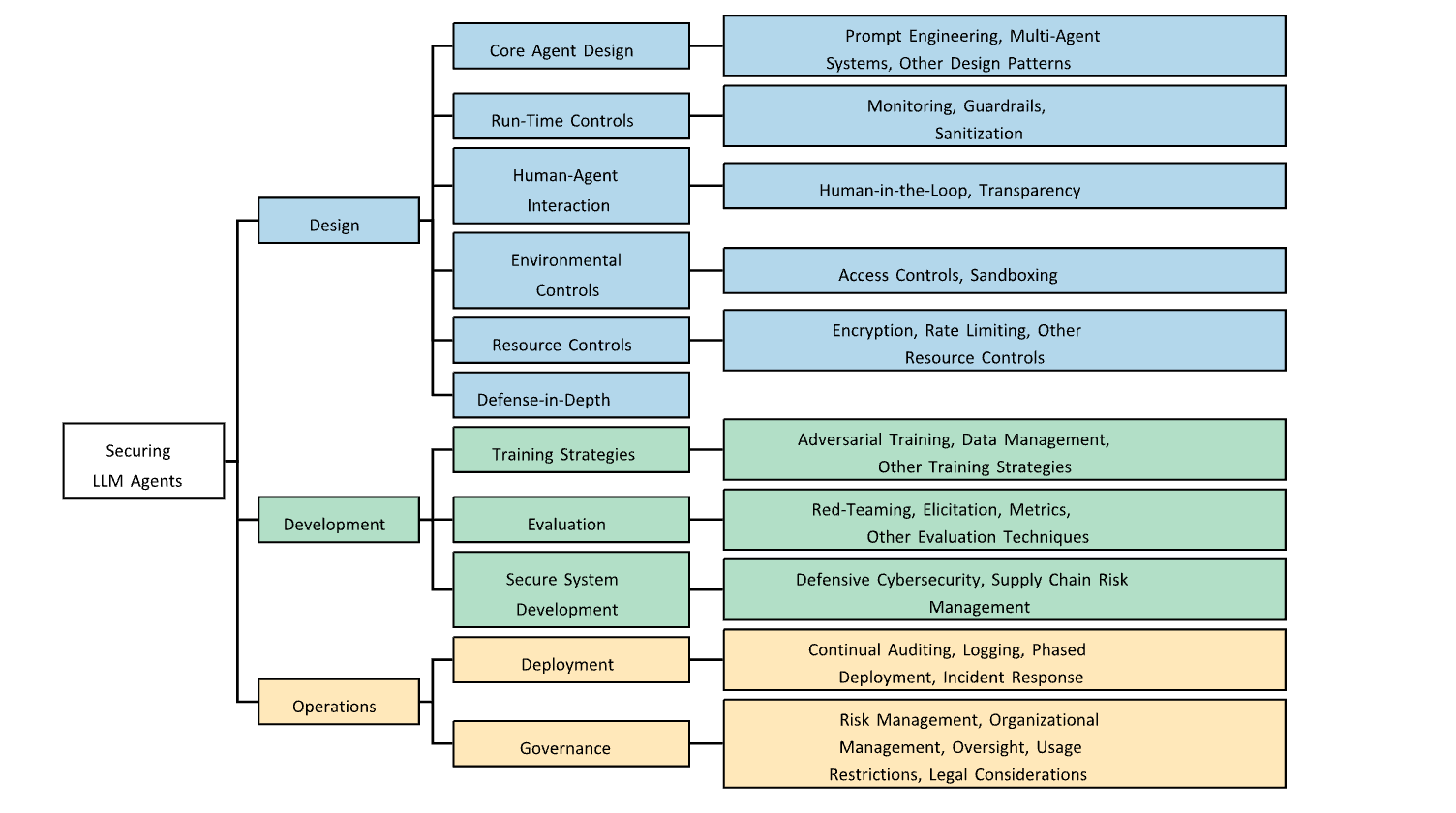

Best practice di sicurezza: le 3 fasi del ciclo di vita degli agenti LLM

La tassonomia delle best practice di sicurezza è suddivisa in tre fasi del ciclo di vita degli agenti LLM: Design, Development e Operations, e copre trentatré categorie di tecniche e raccomandazioni.

Core agent design

Il prompt engineering enfatizza la fornitura di istruzioni esplicite e non ambigue e la chiara demarcazione dei dati recuperati dagli strumenti per indicare i contenuti non affidabili.

I design multi-agente sfruttano la ridondanza, la critica e il consenso per ridurre gli errori e impedire comportamenti non sicuri.

Gli agenti indipendenti propongono soluzioni e convalidano i risultati incrociandoli, al fine di ridurre le allucinazioni, mentre i multi-agente aiutano a individuare gli errori e a bloccare le azioni dannose.

Run-time controls

Il monitoraggio può esaminare gli input, gli step intermedi, le chiamate ai tool e gli output di un agente.

Le tecniche chiave includono classificatori basati su LLM, rilevazione di anomalie e monitoraggio a livello di rete di comunicazione.

Se i monitor segnalano comportamenti indesiderati o anomali, i guardrail possono bloccare o rifiutare gli input o gli output corrispondenti. La maggior parte delle ricerche ha descritto il blocco o il rifiuto dell’intera interazione, ma alcune hanno suggerito il filtraggio di sotto-componenti, come le chiamate ai tool.

Human-Agent interaction

Gli approcci Human-in-the-Loop garantiscono che gli esseri umani abbiano il controllo e la supervisione delle azioni dell’agente.

Le raccomandazioni principali sono: richiedere una conferma umana esplicita prima di eseguire azioni ad alto rischio o irreversibili e consentire l’interruzione dell’esecuzione dell’agente in qualsiasi momento.

Environmental controls

I controlli di accesso regolano i sistemi, i dati e le risorse con cui gli agenti possono interagire.

Tutte le interazioni devono essere autenticate e autorizzate mediante permessi basati su ruoli e attività specifiche. I permessi dovrebbero essere granulari e le fonti dei dati e le capacità degli strumenti dovrebbero essere suddivise per supportare tale approccio.

Il sandboxing limita l’operatività di un agente entro confini sicuri, riducendo così

l’esposizione a sistemi esterni.

Ambienti di esecuzione isolati possono contenere azioni malevole da parte dell’agente o bloccare gli attacchi esterni.

Resource controls

Le misure di sicurezza progettate per i dati o per altre risorse associate o utilizzate da un agente rientrano nei controlli delle risorse.

I dati utilizzati da un agente, così come tutte le comunicazioni inviate tramite una rete, devono essere crittografati sia durante il trasferimento che a riposo.

È necessario crittografare le parti fondamentali del sistema dell’agente, inclusi i prompt e i pesi dei modelli, per prevenire i furti.

La limitazione della velocità riduce la quantità di comunicazioni, dati o altre risorse disponibili per un agente.

Occorre impostare dei limiti relativi al tempo di esecuzione, all’utilizzo della CPU, all’archiviazione dei dati e all’uso degli strumenti per evitare un uso eccessivo. I limiti di velocità possono essere impostati dinamicamente in base a modelli comportamentali o storici per una migliore allocazione delle risorse.

I controlli sulla privacy includevano principalmente misure standard quali la riduzione al minimo della conservazione dei dati e la loro elaborazione locale. Per quanto riguarda i controlli sulla memoria, è consigliabile eseguire scansioni periodiche dei sistemi di memoria degli agenti per bloccare o modificare le voci di memoria dannose.

Si consiglia inoltre di limitare la durata di conservazione delle informazioni nella memoria e di consentire agli utenti di controllare quali informazioni vengono memorizzate.

Defense-in-Depth

La difesa in profondità è una strategia di sicurezza che prevede l’utilizzo di tecnologie di sicurezza eterogenee stratificate, in modo che gli attacchi sfuggiti a una tecnologia possano essere intercettati da un’altra.

Questo principio è stato esplicitamente citato in molte ricerche, mentre altre hanno utilizzato terminologie correlate, come i controlli di sicurezza a più livelli.

Sebbene la difesa in profondità possa comprendere misure di sicurezza per l’intera tassonomia, la collochiamo sotto la voce “Design” per sottolineare che questo approccio deve essere preso sul serio fin dall’inizio.

Development: Training strategies

L’adversarial training prevede l’esposizione di un modello a degli attacchi avversari e il suo addestramento per renderlo robusto a tali attacchi.

La letteratura raccomanda l’adversarial training per una varietà di minacce alla sicurezza, oltre agli esempi avversari tradizionali quali l’iniezione di prompt e la collusione multi-agente.

Per gestire le minacce ai dati di addestramento, la ricerca ha principalmente

raccomandato di filtrare i dati corrotti o avvelenati dai dataset di addestramento, al fine di prevenire gli attacchi backdoor, e di applicare la privacy differenziale o altre tecniche di protezione della privacy, per ridurre la perdita di privacy.

Evaluation

Un red teaming può prevedere l’emulazione di potenziali attacchi a un sistema per identificarne le vulnerabilità e individuare le opportunità per migliorarne le difese.

Per quanto riguarda gli agenti, la letteratura sottolinea l’importanza di sottoporre a red teaming l’intera superficie di minaccia e tutti i componenti del sistema, affrontando una varietà di preoccupazioni in materia di sicurezza.

L’elicitation delle capacità consiste nell’individuare l’intera gamma di comportamenti o abilità che un agente può manifestare, al fine di valutarne accuratamente i rischi per la sicurezza.

Quando si valutano gli agenti LLM, soprattutto per quanto riguarda il potenziale uso improprio di capacità pericolose, è fondamentale che l’elicitation sia condotta con precisione per evitare di sottovalutare le preoccupazioni in materia di sicurezza.

Secure system development

La maggior parte delle pratiche di cybersecurity difensiva include i principi tradizionali DevSecOps, quali il controllo delle versioni, la gestione delle configurazioni, la gestione delle vulnerabilità, l’analisi statica e dinamica e il testing integrato.

Le API e gli ambienti di training e produzione sono stati individuati come le principali superfici di minaccia da mettere in sicurezza.

Il Supply Chain Risk Management dovrebbe riguardare l’intero sistema, inclusi hardware, dipendenze software, modelli, strumenti e dati esterni.

Le mitigazioni specifiche includono l’ispezione dei parametri del modello per individuare eventuali backdoor, l’esecuzione di valutazioni di sicurezza dei fornitori, la scansione, l’audit e il pinning delle dipendenze.

Operations: Deployment

Questo insieme di raccomandazioni sottolinea che la valutazione dovrebbe essere un processo continuo durante il deployment, in quanto nuove preoccupazioni possono emergere a causa di domain shift, edge case o attacchi non previsti.

L’auditing continuo si affida spesso al logging per raccogliere e analizzare le interazioni degli agenti.

Per supportare l’auditing continuo, la letteratura raccomanda di registrare quante più informazioni possibili sull’esecuzione di un agente.

I log possono anche supportare i protocolli di risposta agli incidenti, gli strumenti di supervisione o i monitor inter-query.

Governance

Il risk management inizia con un approccio strutturato al threat modeling, che prevede l’analisi di potenziali threat actor, percorsi di attacco, asset vulnerabili e possibili conseguenze, al fine di stimare il rischio.

Questo processo dovrebbe basarsi su tassonomie di minacce esistenti, ricerche emergenti e risultati di valutazione e red teaming.

Per aumentare la resilienza contro i rapidi cambiamenti delle responsabilità lavorative e del panorama della sicurezza causati dall’integrazione diffusa degli agenti, le organizzazioni dovrebbero investire nella formazione dei lavoratori in materia di alfabetizzazione all’intelligenza artificiale e di raccomandazioni di sicurezza.

In particolare, i team di sicurezza devono essere costantemente aggiornati sui vettori di attacco emergenti e sulle migliori pratiche di red teaming.

Analisi delle best practice

La tassonomia fornisce un’ampia gamma di tecniche pratiche che possono migliorare la sicurezza degli agenti.

Molte di queste categorie hanno ricevuto un ampio consenso da parte del mondo accademico e dell’industria. Tuttavia, l’enfasi sulla difesa in profondità evidenzia il fatto che gli agenti, come tutto il software, sono fondamentalmente insicuri.

Sono stati trovati riferimenti ripetuti a tecniche fondamentali per la sicurezza del software e a estensioni delle linee guida sulla sicurezza informatica già esistenti per gli agenti.

Molte delle migliori pratiche nelle categorie di cyber security difensiva, gestione del rischio della supply chain e crittografia possono essere applicate a quasi tutti i sistemi software, indipendentemente dalla presenza di componenti AI.

L’industria ha dominato la guida per otto delle nove categorie foglia nello stadio Operations. Ciò evidenzia le differenze strutturali tra i punti di forza dell’accademia e dell’industria.

La guida industriale è spesso basata sull’esperienza diretta di implementazione, un’esperienza che i ricercatori accademici non possono generalmente acquisire direttamente.

I casi di studio analizzati forniscono poche informazioni sul core agent design e sulle sue strategie di addestramento, in particolare nelle sottocategorie di prompt engineering, sistemi multi-agente, addestramento avversario e gestione dei dati di addestramento.

Questi componenti dell’intelligenza artificiale degli agenti LLM li distinguono dal software tradizionale e rappresentano quindi un elemento cruciale della proprietà intellettuale.

Le soluzioni adottate hanno spesso dato la priorità a misure di sicurezza che tutelano la privacy degli utenti e forniscono loro il controllo sul comportamento degli agenti. I controlli delle risorse implementati nei casi di studio si sono focalizzati principalmente sulla crittografia e sulla minimizzazione della conservazione dei dati degli utenti.

Ciò suggerisce che gli impegni verso standard di sicurezza pubblici o audit esterni aumentino l’accountability organizzativa.

Raccomandazioni

I risultati rivelano un approccio complementare alla sicurezza degli agenti LLM tra il lavoro accademico e quello industriale, che spesso si concentra sulle differenze tra ricerca e produzione o tra l’intelligenza artificiale e la sicurezza informatica.

Queste differenze non solo rafforzano l’utilità della metodologia di revisione, ma evidenziano anche le opportunità di collaborazione per affrontare in modo più efficace le preoccupazioni pratiche in materia di sicurezza.

Sebbene questo articolo si sia focalizzato sulla letteratura relativa agli agenti LLM, le tassonomie si sovrappongono alle minacce e alle best practice note per gli LLM.

Le minacce interne, che si concentrano sulle modalità di fallimento più comuni degli LLM, come le allucinazioni, sono state la superficie di minaccia più comunemente citata.

I contributi forniscono un framework per l’analisi del panorama della sicurezza, la valutazione del rischio di particolari minacce e lo sviluppo di strategie di mitigazione basate su controlli di sicurezza che godono del consenso generale.

L’applicazione pratica in due esempi

Attacchi a knowledge-base e Denial-of-Service (Dos) sono due esempi.

Gli attacchi alla knowledge base mettono a repentaglio le fonti di dati da cui gli agenti traggono le informazioni, come i database RAG o i sistemi di memoria.

Queste vulnerabilità relative alle risorse sono direttamente collegate ai controlli sulle risorse: la crittografia e i controlli sulla privacy mitigano le preoccupazioni sulla privacy relative alla conservazione di dati potenzialmente sensibili, mentre i controlli sulla memoria possono eliminare le voci di memoria avvelenate per evitare che influenzino il comportamento del modello.

Per difendersi dagli attacchi DoS, è necessario limitare il numero di richieste e l’utilizzo delle risorse da parte di singoli individui o gruppi di utenti. È necessario monitorare l’utilizzo anomalo e bloccare gli account offensivi. I sistemi dovrebbero essere sottoposti a test di penetrazione contro gli attacchi DoS per verificare che le misure di protezione siano adeguate.

Una visione d’insieme della sicurezza degli agenti LLM

Gli agenti LLM devono affrontare una vasta gamma di minacce che rappresentano un rischio significativo per chi li costruisce e li utilizza.

Tuttavia, a causa della frammentazione delle linee guida tra le varie fonti, gli sviluppatori e le organizzazioni faticano a seguire un percorso coerente verso la sicurezza.

Questa revisione sistematica del panorama della sicurezza degli agenti LLM chiarisce quali minacce devono affrontare, quali tecniche sono disponibili per proteggerli e come vengono effettivamente messi in sicurezza.

Sintetizzando gli insight provenienti dall’accademia, dall’industria e dai deployment reali, i risultati unificano le conoscenze precedentemente frammentate, offrendo una visione d’insieme dello stato attuale della sicurezza degli agenti LLM.

I contributi includono una categorizzazione delle minacce agli agenti LLM, una tassonomia di pratiche di sicurezza attuabili, una valutazione dell’adozione in casi reali e una dimostrazione di come questi elementi possano essere combinati in valutazioni del rischio ripetibili.

Per garantire la sicurezza degli agenti LLM, sarà necessario uno sforzo congiunto da parte del mondo accademico, dell’industria e del governo, che coinvolga i settori dell’intelligenza artificiale e della sicurezza informatica.

Ora è il momento di supportare il settore nello sviluppo di processi standardizzati e ripetibili per la creazione di agenti LLM sicuri.

Riferimenti

[1] A. Chan, R. Salganik, A. Markelius, C. Pang, N. Rajkumar, D. Krasheninnikov, L. Langosco, Z. He, Y. Duan, M. Carroll, M. Lin, A. Mayhew, K. Collins, M. Molamohammadi, J. Burden, W. Zhao, S. Rismani, K. Voudouris, U. Bhatt, A. Weller, D. Krueger, and T. Maharaj. “Harms from Increasingly Agentic Algorithmic Systems.” In Proceedings of the 2023 ACM Conference on Fairness, Accountability, and Transparency. Pages 651–666. 2023.

[2] K. Huang. “Agentic AI Threat Modeling Framework: Maestro.” Cloud Security Alliance Blog. February 2025. [Online].

[3] A. P. Siddaway, A. M. Wood, and L. V. Hedges. “How to Do a Systematic Review: A Best Practice Guide for Conducting and Reporting Narrative Reviews, Meta-Analyses, and Meta-Syntheses.” Annual Review of Psychology. Volume 70. Number 1. Pages 747–770. 2019.

[4] M. Howard and S. Lipner. The Security Development Lifecycle. Microsoft Press. Volume 8. 2006.

[5] K. Greshake, S. Abdelnabi, S. Mishra, C. Endres, T. Holz, and M. Fritz. “Not What You’ve Signed Up For: Compromising Real-World LLM-Integrated Applications With Indirect Prompt Injection.” In Proceedings of the 16th ACM Workshop on Artificial Intelligence and Security. New York, NY, USA: Association for Computing Machinery.

Pages 79–90. 2023.

[6] E. Wallace, K. Xiao, R. Leike, L. Weng, J. Heidecke, and A. Beutel. “The Instruction Hierarchy: Training LLMs to Prioritize Privileged Instructions.” arXiv. Volume abs/2404.13208. 2024.

[7] MITRE Corporation. “MITRE ATLAS: Adversarial Threat Landscape for Artificial-Intelligence Systems.” MITRE. December 2024. [Online]. Available:

https://atlas.mitre.org.

[8] H. Booth, M. Souppaya, A. Vassilev, M. Ogata, M. Stanley, and K. Scarfone. “Secure Software Development Practices for Generative AI and Dual-Use Foundation Models: An SSDF Community Profile.” NIST Special Publication 800-218A. July 2024. [Online]. Available: https://doi.org/10.6028/NIST.SP.800-218A.

[9] OWASP GenAI Security Project. “OWASP Top 10 for Large Language Model

Applications (Version 2025).” OWASP. November 2024. [Online]. Available:

https://owasp.org/www-project-top-10-for-lar ge-language-model-applications/