L’integrazione sempre più profonda dell’intelligenza artificiale nei browser web sta inaugurando una nuova fase di vulnerabilità informatica.

Gli esperti avvertono che gli AI browser – software capaci di rispondere a domande, riassumere pagine, eseguire comandi e agire autonomamente su siti web – rappresentano un potenziale punto di svolta per la sicurezza digitale, aprendo un campo inesplorato di minacce note e sconosciute.

Indice degli argomenti

ChatGPT Atlas e Copilot Mode per Edge: la trasformazione degli AI browser

L’attenzione si è concentrata su questa nuova categoria di applicazioni, mentre OpenAI e Microsoft presentavano, rispettivamente, ChatGPT Atlas e la Copilot Mode per Edge.

A queste si affiancano altri progetti come l’integrazione di Gemini in Chrome da parte di Google, Opera con il suo progetto sperimentale Neon, e Dia di The Browser Company.

Anche startup emergenti, tra cui Perplexity con il browser Comet e la svedese Strawberry – ancora in beta e rivolta agli “utenti delusi di Atlas” – stanno cercando di conquistare spazio in un settore che promette di ridefinire il modo stesso di navigare in rete.

La trasformazione è profonda: ciò che un tempo erano chatbot isolati in app o pagine dedicate sta diventando parte integrante del browser, ossia il principale strumento di accesso a Internet.

Tuttavia questa integrazione comporta un rischio intrinseco.

I rischi degli AI browser

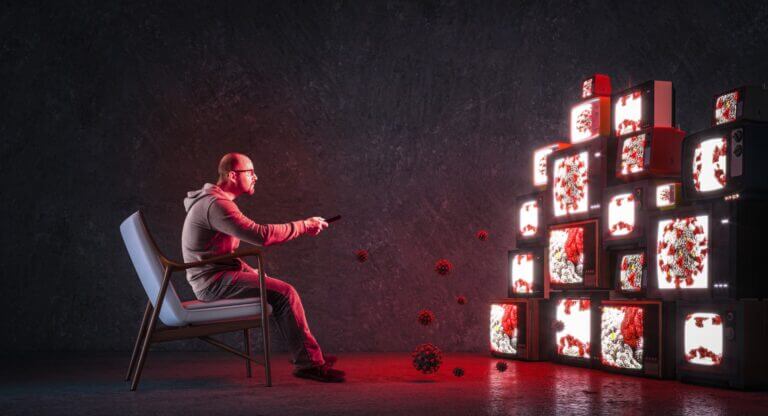

L’unione tra intelligenza artificiale, memoria persistente e accesso continuo ai dati utente crea un ecosistema con un potenziale di attacco significativamente ampliato.

Secondo Hamed Haddadi, docente all’Imperial College di Londra e chief scientist presso Brave, l’attuale scenario mostra solo la superficie del problema: l’ampiezza della superficie d’attacco è “vastissima”, e le vulnerabilità emerse nelle prime versioni degli AI browser ne sono un chiaro indicatore.

La vulnerabilità in ChatGPT Atlas

Negli ultimi mesi, ricercatori hanno individuato vulnerabilità in ChatGPT Atlas che avrebbero potuto consentire di sfruttare la memoria del modello per iniettare codice malevolo o ottenere privilegi non autorizzati.

Altri bug, come quelli rilevati nel browser Comet di Perplexity, permettevano l’iniezione di istruzioni nascoste per prendere il controllo dell’assistente AI integrato.

Le stesse aziende coinvolte hanno riconosciuto la criticità del fenomeno: OpenAI e Perplexity hanno definito i cosiddetti prompt injection attacks (attacchi tramite vulnerabilità di Large Language Model o LLM) un problema “di frontiera”.

L’aspetto più insidioso di questi attacchi risiede nella natura stessa degli agenti intelligenti. A differenza degli utenti umani, gli assistenti AI non possiedono esperienza o prudenza: possono visitare siti malevoli, cliccare su link pericolosi o inserire dati sensibili in contesti inappropriati.

In molti casi, è sufficiente un’istruzione nascosta in un’immagine, in un campo di testo o persino in una riga di testo bianco su sfondo bianco per compromettere l’intero sistema.

Lukasz Olejnik, ricercatore indipendente e visiting fellow al King’s College London, paragona la situazione alle prime fasi di altre rivoluzioni tecnologiche: dalle macro di Microsoft Office agli script dei browser, fino alle app mobili prima dell’introduzione dei permessi.

Ogni innovazione, osserva, porta con sé una nuova ondata di vulnerabilità. Il rischio più grande, oggi, è la fretta con cui le aziende stanno rilasciando i prodotti per competere nel mercato dell’intelligenza artificiale integrata.

AI browser: l’esposizione dei dati in caso di attacco

A rendere la situazione ancora più complessa è la quantità di dati raccolti da questi nuovi browser.

Funzioni come la “memoria AI” registrano e apprendono dai comportamenti dell’utente – cronologia, ricerche, mail e conversazioni – creando profili personali di una granularità senza precedenti.

Secondo Yash Vekaria, ricercatore all’Università della California (Davis), questo porta a “un rischio imminente di tracciamento e profilazione da parte del browser stesso”.

Se tali informazioni venissero esposte a un attacco, le conseguenze potrebbero essere gravi: combinando memoria conversazionale, credenziali salvate e dati di pagamento, un hacker avrebbe accesso diretto alla vita digitale dell’utente.

L’automazione amplifica anche il pericolo di attacchi ripetuti, in cui l’agente AI viene progressivamente manipolato fino a compiere azioni indesiderate.

Come spiega Haddadi, l’interazione continua tra agenti e utenti crea infinite opportunità per testare e perfezionare tecniche di manipolazione, aprendo così la strada a violazioni difficili da individuare e contenere.

Shujun Li, professore di cybersecurity all’Università del Kent, avverte che il numero di vulnerabilità zero-day sta crescendo in modo esponenziale con l’avvento dei browser basati su agenti AI.

Poiché questi sistemi agiscono autonomamente, spesso senza monitoraggio diretto, la rilevazione degli attacchi avviene con ritardo, incrementando la gravità dei potenziali danni.

La mitigazione dei rischi

Si delineano così scenari in cui un agente compromesso potrebbe, per esempio, inviare informazioni personali a soggetti terzi o modificare in modo invisibile un indirizzo di consegna durante un acquisto online.

Olejnik avverte che tali attacchi potrebbero essere eseguiti anche da utenti con competenze tecniche moderate, data la relativa semplicità con cui oggi è possibile inserire comandi invisibili nei contenuti web.

Di fronte a questi rischi, la comunità di ricerca è concorde nel sottolineare la necessità di test più approfonditi e di un rallentamento dei rilasci commerciali. Tuttavia, la pressione competitiva tra i principali attori del mercato rende improbabile un approccio prudente.

Secondo Li, l’unico modo realmente efficace per limitare l’esposizione è ridurre l’uso dell’intelligenza artificiale ai casi in cui sia strettamente necessario. L’adozione di un “AI-free mode” di default, attivando l’agente solo su richiesta esplicita, rappresenterebbe una soluzione temporanea per limitare la raccolta e la condivisione dei dati sensibili.

Vekaria suggerisce inoltre un controllo diretto sulle fonti utilizzate dagli agenti: fornire manualmente i siti di riferimento anziché lasciare al browser la libertà di esplorare il web.

In assenza di tali precauzioni, gli assistenti potrebbero “suggerire o utilizzare siti fraudolenti”, con esiti potenzialmente disastrosi per la sicurezza personale e aziendale.

Fra autonomia algoritmica e responsabilità umana

Nel complesso, il dibattito sugli AI browser non riguarda solo una nuova generazione di strumenti digitali, ma la ridefinizione del confine tra autonomia algoritmica e responsabilità umana.

Ogni passo verso l’automazione cognitiva – dove il browser non è più un semplice intermediario ma un agente attivo – richiede una riflessione profonda sulla sicurezza, la privacy e la fiducia nelle interfacce che quotidianamente mediano l’accesso all’informazione.

La corsa ad integrare l’intelligenza artificiale nella navigazione web, se non accompagnata da standard di sicurezza rigorosi e verifiche indipendenti, rischia di trasformare il browser in un nuovo vettore di attacco globale.