L’integrazione rapida dell’intelligenza artificiale nelle operazioni aziendali ha rivoluzionato l’efficienza, aprendo nuove opportunità per ottimizzare i flussi di lavoro e migliorare i processi decisionali.

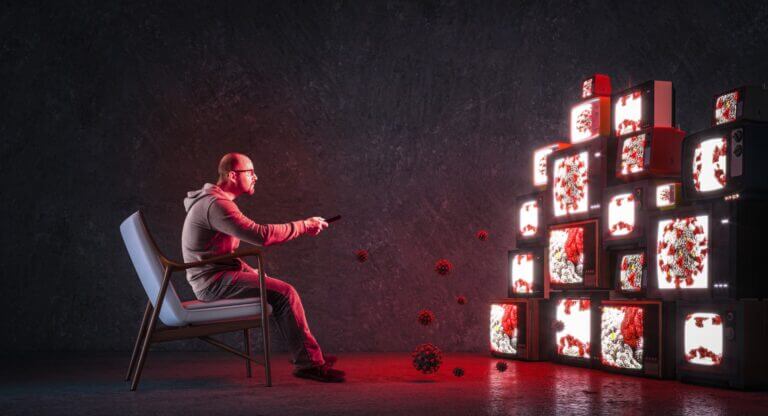

Tuttavia, l’adozione di questi potenti strumenti comporta anche dei rischi. Una delle minacce emergenti è il prompt hacking o prompt injection: la manipolazione degli input in linguaggio naturale utilizzata dai criminali per indurre i modelli a generare output dannosi.

La storia si ripete: abbiamo già visto tattiche simili in passato. Ecco cosa rende questa minaccia particolarmente difficile da affrontare.

Indice degli argomenti

Prompt hacking: cosa preoccupa

Proprio come i famigerati attacchi SQL injection dei primi anni 2000, il prompt hacking sfrutta le vulnerabilità nel modo in cui i sistemi interpretano l’input dell’utente.

Per esempio, un utente malintenzionato può creare con cura un prompt per ingannare un sistema di IA e spingerlo a rivelare informazioni sensibili, eseguire azioni non autorizzate o interrompere le operazioni.

Poiché i sistemi di IA sono ormai integrati in processi come la comunicazione con i clienti, la gestione delle buste paga e dei dati, le conseguenze della manipolazione dei prompt possono essere catastrofiche.

Un singolo attacco di questo tipo può causare perdite finanziarie, interruzioni del servizio o danni reputazionali che richiedono anni per essere riparati.

Ciò che rende questa minaccia particolarmente difficile da affrontare è la sua bassa soglia di accesso. Il prompt hacking non richiede competenze tecniche avanzate, poiché la manipolazione avviene attraverso il linguaggio naturale e non mediante codice di programmazione.

Poiché questi attacchi si basano sulle parole e non su vulnerabilità tecniche, possono risultare sorprendentemente difficili da rilevare e da prevenire.

Questa accessibilità amplia il numero potenziale di malintenzionati e alza la posta in gioco per chi deve adottare strategie di mitigazione efficaci.

Alzare l’asticella della sicurezza

Il principale cambiamento di mentalità richiesto ai team IT è comprendere che non esiste un unico vettore d’attacco o un singolo esito nel prompt hacking. Devono iniziare a pensare a “problemi malevoli” invece che a “codice malevolo”.

Adottare un framework di sicurezza Zero Trust è un modo efficace per affrontare questa sfida. Questo approccio si basa sul principio che nessun utente, sistema o interazione debba essere considerato attendibile di default.

Zero Trust dà priorità alla verifica continua, il che significa che le aziende devono monitorare tutti i prompt e gli input per individuare comportamenti anomali, indipendentemente dalla loro origine o legittimità percepita.

Proteggere l’integrazione dell’IA significa anche adattare le pratiche di sicurezza per riconoscere i rischi unici posti dalla manipolazione del linguaggio.

Invece di concentrarsi esclusivamente sui “problemi di codice” tecnici, le aziende devono ora anticipare pattern di input malevoli o “prompt problematici” in grado di aggirare le misure di protezione.

Integrando la sicurezza in ogni aspetto delle operazioni basate sull’IA, dall’architettura dei sistemi alle autorizzazioni dei flussi di lavoro, le aziende possono operare nel futuro guidato dall’intelligenza artificiale con maggiore fiducia e minori rischi.

Il vaso di Pandora è stato aperto

Il prompt hacking rappresenta un vaso di Pandora di sfide che le aziende non

possono permettersi di ignorare.

Man mano che i sistemi di IA diventano sempre più integrati nelle funzioni aziendali centrali, i rischi associati alla manipolazione dei prompt continuano ad aumentare.

Poiché non si tratta di un problema teorico, affrontare questa minaccia non può essere un intervento una tantum, ma deve diventare una responsabilità continua, che richiede aggiornamenti costanti a policy, sistemi e programmi di formazione dei dipendenti a ogni livello.

La rivoluzione dell’intelligenza artificiale è già arrivata e sta trasformando radicalmente interi settori e creando vantaggi competitivi per chi è disposto ad

abbracciarne le possibilità.

Tuttavia, sfruttarne il potenziale in modo sicuro significa impegnarsi in una strategia di difesa proattiva, che includa robuste misure di protezione, salvaguardi i dati e i processi sensibili, applichi il principio del minimo accesso alle informazioni e preservi la fiducia dei clienti.